Face à la polémique, Apple tente d’apporter des réponses.

Apple veut analyser les photos stockées sur iCloud. © ink drop – stock.adobe.com

À l’occasion du CES 2019 à Las Vegas, Apple avait diffusé une publicité gigantesque sur un building. « What happens on your iPhone, stays on your iPhone », une allusion à l’expression « ce qui se passe à Vegas reste à Vegas » pour troller ses concurrents. Deux ans plus tard, Apple ouvre des brèches qui inquiètent les observateurs.

Les faits

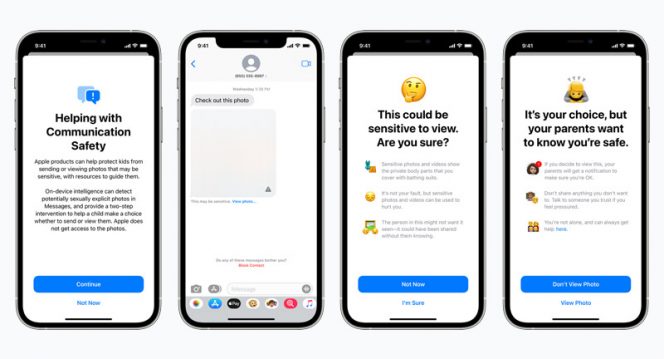

Apple a annoncé ce jeudi la mise en place d’actions pour protéger les enfants. « Nous voulons aider à protéger les enfants contre les prédateurs qui utilisent des outils de communication pour les recruter et les exploiter, et limiter la diffusion de matériel pédopornographique ». Concrètement :

- L’application Messages utilisera du machine learning local, sur l’iPhone, pour repérer les « contenus sensibles » et avertir les utilisateurs.

- iOS et iPadOS utiliseront « de nouvelles applications de cryptographie » pour limiter la diffusion de matériel pédopornographique. Apple précise que cette technologie permettra de « fournir des informations précieuses aux forces de l’ordre concernant le stockage de photos pédopornographiques sur iCloud ».

Apple interviendra également quand les utilisateurs de Siri et du Search tenteront de réaliser des recherches qui correspondent à du contenu pédopornographique.

La problématique

Si l’objectif visé par Apple est évidemment légitime, il pose de nombreuses questions sur la confidentialité des correspondances privées.

De nombreux acteurs accusent Apple de créer une backdoor pouvant être utilisée à des fins de surveillance, notamment. Une lettre ouverte demande à Apple de revenir sur sa décision : An Open Letter Against Apple’s Privacy-Invasive Content Scanning Technology. Parmi les signataires, des organisations comme l’EFF (Electronic Frontier Foundation) et des personnalités comme Edward Snowden.

Apple plans to modify iPhones to constantly scan for contraband:

“It is an absolutely appalling idea, because it is going to lead to distributed bulk surveillance of our phones and laptops,” said Ross Anderson, professor of security engineering. https://t.co/rS92HR3pUZ

— Edward Snowden (@Snowden) August 5, 2021

La semaine dernière, un article de The Information avait été à l’origine d’une autre polémique : le média expliquait que Facebook montait une équipe de chercheurs pour développer des applications liées au chiffrement homomorphe. La source indiquait que cette technologie pourrait permettre à Facebook d’analyser les messages WhatsApp tout en garantissant la confidentialité des échanges. Le responsable de WhatsApp a rapidement démenti l’information, indiquant très justement : « nous devrions être sceptiques quant aux affirmations techniques selon lesquelles des applications comme la nôtre ne pourraient voir les messages que dans les « bons » cas. Ce n’est tout simplement pas comme cela que la technologie fonctionne ».

Oui, ce n’est tout simplement pas comme cela que la technologie fonctionne. Et c’est suffisamment rare pour être souligné, WhatsApp semble aujourd’hui plus prudent qu’Apple, désormais accusé d’ouvrir une brèche dans la vie privée de ses utilisateurs.

Les réponses d’Apple

Apple tente d’éteindre l’incendie provoqué par sa décision. L’entreprise publie une FAQ de 13 questions/réponses. Apple indique notamment qu’il refusera toute demande gouvernementale visant à inclure dans l’analyse des photos iCloud d’autres contenus que ceux qui correspondent à du matériel pédopornographique (CSAM, Child Sexual Abuse Material). Apple précise aussi que ses systèmes sont conçus pour éviter que cette technologie soit utilisée pour repérer d’autres contenus et qu’elle est nécessairement basée sur un échantillon de photos fournie et validée par la NCMEC, une ONG qui lutte contre l’exploitation des enfants. Il n’y a pas de transmission automatique des coordonnées des suspects aux autorités, une analyse humaine est systématiquement réalisée en amont. C’est rassurant, tant ces outils automatiques sont sujets à erreurs, même si Apple indique que son mécanisme est « particulièrement précis » ; signe d’une nécessité d’un matching à 100 % pour lancer l’alerte ? Apple indique également que cette analyse sera limitée aux photos stockées sur iCloud, les photos uniquement stockées sur l’iPhone ne seront pas analysées.

L’EFF estime tout de même « qu’une porte dérobée, même soigneusement documentée, soigneusement réfléchie et à portée étroite est toujours une porte dérobée ». À ce sujet, chacun aura son propre avis : certains estimeront « qu’ils n’ont rien à cacher » et que l’objectif visé est parfaitement légitime. Ils auront évidemment raison concernant la légitimité de l’objectif visé, mais comme le dit si justement l’EFF, une backdoor reste une backdoor. Ces décisions d’Apple dégradent de facto le degré de confidentialité garanti aux utilisateurs, puisque toutes leurs photos stockées sur iCloud pourront être scannées.

Une société où tout est contrôlé par les autorités, ou dans ce cas précis, par les entreprises privées, où des caméras et des capteurs jalonnent les rues et où chaque échange sous forme de texte, photo ou vidéo est analysé, serait sans aucun doute une société plus sûre ; mais est-ce la société dans laquelle nous souhaitons vivre ? Nous n’en sommes évidemment pas là avec cette « simple analyse » des photos par Apple, et encore une fois : le but recherché est on ne peut plus légitime. Mais ce genre de décision amène nécessairement vers un contrôle des correspondances privées et du stockage, et pose de vraies questions sur la remise en cause de la confidentialité des données.

Recevez par email toute l’actualité du digital